El pionero de la IA en España desvela la verdad detrás del marketing tecnológico y la (no) cercanía de la AGI.

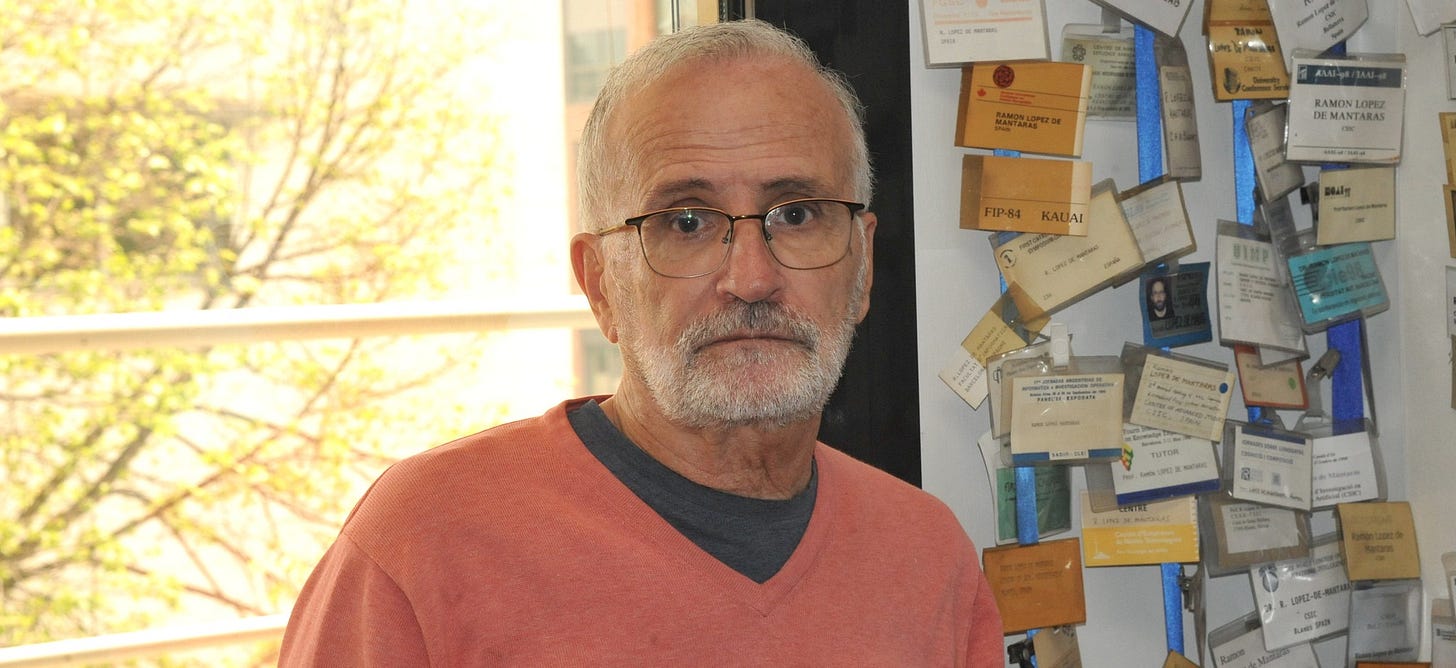

La entrevista con Ramón López de Mántaras, uno de los pioneros más relevantes de la Inteligencia Artificial en España y Catalunya, para este boletín Algoritmo Transparente número 86 y publicada en catalán en la sección IA per a tothom del diario El Punt Avui.

Ramón López de Mántaras Badia (Sant Vicenç de Castellet, 1952) es ingeniero de electrónica, estudió en Mondragón, Toulouse y Berkeley y, al volver a España, abrió camino con investigaciones inéditas en IA. Ha conocido a todas las grandes figuras de la IA a nivel global y ahora es muy crítico con la forma en que se está promocionando esta tecnología.

¿Podríamos decir que eres uno de los pioneros de la IA en el Estado español? Posiblemente porque empecé a hacer mi tesis doctoral en inteligencia artificial en Toulouse en 1974 y la terminé en 1977. En 1974, aunque estaba en Francia, había poquísima gente que hiciera IA. Podríamos decir que soy de los primeros en hacer IA en Europa. De hecho, mi tesis, en la que introducía dos nuevos algoritmos de aprendizaje probabilístico para que una mano robótica antropomórfica aprendiera a reconocer objetos solo a partir de los datos de sensores táctiles, la leí en 1977 y fue de las 4 o 5 primeras tesis sobre IA aplicada a la robótica que se hicieron en Francia.

Y de las primeras europeas. En aquel momento quizás se habían hecho alrededor de una decena en Europa en IA aplicada a la robótica.

¿De qué año es tu primera publicación? De junio de 1976, en un congreso en Suecia. Es de los primeros trabajos sobre machine learning en Europa: un algoritmo de auto-aprendizaje para la clasificación y reconocimiento de patrones vectoriales. Objetivamente, fui de los primeros en trabajar en machine learning en Europa.

De españoles y catalanes, de los primerísimos. Después de Francia fui a Berkeley, y me especialicé en inteligencia artificial porque mientras estaba en Toulouse ya había bastante actividad en el campo llamado Pattern Recognition pero en aquella época era un campo que todavía no estaba incluido dentro de lo que ahora llamamos IA. En mi tesis los algoritmos que inventé hacían pattern recognition táctil. Esto casi nadie lo había hecho. Todo el mundo hacía pattern recognition en base a visión artificial. En Estados Unidos había unos congresos especializados en reconocimiento de formas, y de inteligencia artificial hacía poco que existían congresos, desde finales de los 60 o primeros de los 70. En Europa no se hablaba mucho de IA, era algo muy desconocido. Cuando vino a Toulouse el profesor Lotfi A. Zadeh [creador de la teoría de los conjuntos difusos y la lógica difusa] dio una conferencia sobre IA.

"Soy muy crítico con la antropomorfización de la IA, y nos quieren vender la moto de que la IA General a nivel humano está a la vuelta de la esquina."

¿Es la primera vez que oyes hablar de IA? Era la primera vez que oía hablar de inteligencia artificial propiamente. Era en 1975 en Toulouse. Yo pensé: "Si esto es muy similar a lo que estoy haciendo yo con mi tesis". La defendí en 1977. Zadeh explicó que una de las cosas que se hacía en IA es el aprendizaje automático, hacer que las máquinas aprendan. ¡Mi tesis iba de eso! Resulta que estaba trabajando en un tema que, sobre todo en Estados Unidos y Escocia, en Edimburgo, porque fueron muy pioneros, era la inteligencia artificial. Yo, muy entusiasmado por todo esto, hablé con Lotfi Zadeh [1921-2017] y me animó a que me presentara como candidato a la Universidad de Berkeley para hacer un máster en IA bajo su dirección.

¿Qué año fue a Berkeley? En noviembre de 1977. Tesis y boda en Toulouse, y en otoño hacia Estados Unidos. Estuve hasta finales de 1979. Hice un máster en la modalidad investigación, es decir, haciendo menos asignaturas pero había que hacer la tesis.

¿De qué era esta tesis? Hice una extensión de la primera sobre aprendizaje pero ya introduciendo conceptos de algo que se llama lógica difusa o lógica borrosa, fuzzy logic. Yo desarrollé un algoritmo nuevo de aprendizaje que incorporaba modelos basados en esta lógica. Cuando volví aquí, estuve un año dando clases e investigación en Mondragón en el departamento de informática que se acababa de fundar el centro tecnológico Ikerlan, en 1979. Y a finales de 1980 en la UPC necesitaban profesores porque empezaba el grado de informática. Fue, junto con San Sebastián y Madrid, las tres primeras universidades que empezaron la licenciatura en informática en España y me incorporé como profesor. Leí mi tesis doctoral en la Facultad de Informática de Barcelona en 1981. ¡En aquella época era más rápido hacer otra tesis que convalidar la que tenía de Francia! Fue la primera tesis doctoral en informática en Catalunya y la escribí en catalán. A nivel estatal, fue una de las dos o tres primeras tesis en informática.

¿El contexto político de la transición afectaba a un investigador catalán como tú? Yo salí de España pero no por cuestiones políticas. En aquella época Toulouse ya era reconocido como un lugar tecnológicamente muy avanzado. Había toda la industria aeroespacial, los Airbus. Había un alto nivel de electrónica, informática y la automática. Y Estados Unidos obviamente era la Meca de la inteligencia artificial. Fui a aprender a los mejores lugares. La Universidad de Berkeley es de las más prestigiosas del mundo.

¿Y cuándo vuelves en democracia? Yo había tenido toda mi formación en castellano y quería dar las clases en catalán. Fui a clases intensivas de catalán para poder escribir en la pizarra sin cometer faltas. No quería encontrarme con chicas y chicos de 18 años formados en catalán y yo cometer faltas.

¿Cuántos años tenías? Cuando volví de Estados Unidos tenía 27. Y con 28 empiezo a dar clases en la Politécnica, que entonces se llamaba Universidad Politécnica de Barcelona.

Desde entonces, ¿has vivido un gran invierno en relación a la IA? He vivido uno, y otro muy suave. Hubo un invierno que coincidió con mi vuelta de Estados Unidos. A mediados de los 80, los sistemas expertos, que intentaban emular el conocimiento de un experto humano en un tema muy concreto y limitado como por ejemplo el diagnóstico de neumonías extrahospitalarias en adultos, por ejemplo, podían hacer un razonamiento muy deductivo. Hicieron un boom, pero tenían un problema: no evolucionaban, no aprendían. Hubo un primer invierno, que aquí no lo sufrimos mucho porque precisamente Enric Trillas, que me dirigió la tesis en Catalunya, lo nombraron en 1984 presidente del CSIC. Y en 1985 me propuso crear un departamento de inteligencia artificial en el Centro de Estudios Avanzados de Blanes, con Jaume Agustí, de la Autónoma. Por lo tanto, cuando en Estados Unidos e Inglaterra notaron un impacto negativo, un invierno, aquí, en cambio, debido a la iniciativa de Enric Trillas en el CSIC, tuvimos apoyo.

Una primavera. Es curioso. Vas al revés del resto. En aquellos años también el ministerio de Educación y Ciencia español empezó a financiar proyectos de investigación. Se creó un organismo para hacer las primeras convocatorias de proyectos. Nosotros nos presentamos en 1985 y conseguimos un proyecto para trabajar con IA en Blanes. Tuvimos la suerte de que España se empezaba a poner las pilas en investigación y que Enric Trillas fuera presidente del CSIC.

Es la llegada de los socialistas. Felipe González había ganado hacía poco las elecciones.

¿Quién era el ministro? Ahora te lo digo [Teclea su portátil y lo busca por Internet.]

¿Por qué no se lo pides a ChatGPT? Porque de las cosas factuales no me fío. Se puede inventar hechos. Por eso es mucho mejor Google.

"Fuimos los primeros que logramos que una IA generara música con expresividad."

¿La búsqueda tradicional de Internet es más eficiente que la consulta conversacional con una IA? Si quieres información con garantías de veracidad, olvídate de ChatGPT. ¡Y tanto! De mí dice trabajos que no he publicado nunca. Se inventa títulos y mi lugar de nacimiento. ¡Incluso hace pocos días un compañero me dijo que, según ChatGPT, ¡fallecí el año pasado!

Pero ahora tienes el modo de búsqueda dentro de ChatGPT. Sí, ¡pero aún así no lo hace bien!

¿Seguro? El o3 de OpenAI y Claude de Anthropic buscan en Google o Wolfram. Buscan fuera, incorporan y te lo dicen. A pesar de eso, no verifican. Lo meten directamente.

Pero la IA ¿no tiene más capacidad de contrastar fuentes que tú buscando ahora mismo en Google? Podrían tener la capacidad, pero por algún motivo no lo hacen bien. Yo no me fío. Mira: José María Maravall, de 1982 a 1988, ministro de Educación y Ciencia.

¿Con los socialistas cambia la cosa? Cogen y dicen: "Tenemos que hacer que el mundo académico pueda hacer propuestas de investigación que se puedan evaluar y financiar si son buenas". Cogimos este momento.

Una primavera local. Sí, pero no solo de IA sino de la ciencia en general. Antes de los 80 no había convocatorias en todos los ámbitos del saber.

¿Qué proyectos de IA recuerdas? El aprendizaje y los sistemas expertos. En 1987 recibimos, junto con Carles Sierra, el compañero Lluís Godó y el médico Albert Verdaguer, el premio europeo de IA como mejor trabajo en toda Europa. Era en el ámbito médico. El aprendizaje simbólico inductivo, no el probabilístico ni las redes neuronales, era lo que más se trabajaba entonces. Los años 80 no tenían muy buena prensa las redes neuronales.

¿Qué llega después? Las redes bayesianas o modelos gráficos probabilísticos. Esto tiene un impacto muy fuerte a finales de los 80. Viene de Judea Pearl, de la Universidad de California de Los Ángeles. Lo conozco mucho.

De grandes figuras de la IA, ¿a quiénes has conocido? A todos. A la mayoría. Con Marvin Minsky llegamos a ser amigos.

¿A John McCarthy? De los que estuvieron en la Convención de Dartmouth [donde se bautiza el concepto de inteligencia artificial, en 1956] conocí a Marvin Minsky, John McCarthy y Oliver Selfridge. Los tres fallecidos.

¿Y de los vivos? Judea Pearl, Stuart J. Russell... todos. De los vivos, todos.

¿Quién te ha impresionado más? [Piensa] Minsky. También es el que he tratado más. Nos conocimos en 2006, cuando se cumplían 50 años de Dartmouth. Yo di la conferencia de apertura del congreso alemán de inteligencia artificial. En la mesa presidencial del congreso estaba Marvin Minsky. Hablé de un sistema de razonamiento basado en analogía aplicado a la generación de música expresiva. Minsky era pianista y sabía mucho de música. Le gustó mi conferencia porque el razonamiento basado en analogías es cognitivamente plausible. Él era muy crítico con las aproximaciones a la IA que se alejaban de ser cognitivamente plausibles, lo que significa que guardan una cierta relación con la inteligencia humana. Los humanos a menudo resolvemos un problema nuevo no desde cero, sino aprovechando que este problema tiene características similares a problemas previamente resueltos del pasado. Aprovechamos que ya hemos resuelto problemas similares para resolver más fácil y rápidamente el nuevo problema. De eso hablé en esta aplicación a la música. Como a Minsky le apasionaba la música, fue redondo.

Entonces, ¿era revolucionario que la máquina entendiera la lógica del razonamiento del humano? Nos concedieron el premio más importante del mundo en informática musical, el Swets & Zeitlinger en 1998. Fuimos los primeros que logramos que una IA generara música con expresividad. No que suene toda aburrida, neutra y mecánica, sino que hace crescendos, diminuendos, juega con la articulación, el ataque de las notas... Fuimos de los primeros en incorporar 5 variables expresivas en la síntesis de música.

¿Qué reacción tienes cuando escuchas una canción con Suno o Udio? Son capaces de imitar muy bien un estilo ya conocido, pero no pueden romper reglas. No son creativos.

¿No te sorprenderá? No, porque no rompen reglas.

¿La IA todavía es predecible? Sí, porque se entrena con todo lo que ya existe.

¿Y qué pasa en los años 90? Es el boom del machine learning, de hacer que las máquinas aprendan. Y también hay un boom de las redes neuronales.

¿Quién es el padre del resurgimiento de las redes neuronales? El algoritmo backpropagation, que permite que las redes neuronales de muchas capas aprendan, converjan. Uno de los padres es Geoffrey Hinton.

Hinton ahora es muy crítico. Crítico a su manera y, desde mi punto de vista, por motivos erróneos. Yann LeCun, Yoshua Bengio y Geoffrey Hinton son los padrinos del deep learning, el aprendizaje profundo.

¿Tú qué haces en los años 90? En 1991 desarrollo un algoritmo nuevo que permite seleccionar los mejores atributos para construir un árbol de decisión. Permite hacer predicción con algoritmos de clasificación en función de los valores de ciertos atributos. Era un método de selección de atributos completamente nuevo que mejoraba los anteriores. Todo es simbólico, no probabilístico.

Te saca de quicio que se hable de alucinaciones de la IA. Sí, porque estamos antropomorfizando la IA. No hay alucinaciones, hay errores y punto.

Te veo muy crítico. Soy muy crítico con la antropomorfización de la IA, y que nos quieren vender la moto de que la Inteligencia General (AGI) a nivel humano está a la vuelta de la esquina.

¿Es culpa del marketing? Sobre todo del marketing de las grandes tecnológicas que marcan la pauta. Sí que es verdad también que hay resultados académicos que tienen servicios de comunicación que hacen titulares con tendencia a exagerar.

¿Parte de los culpables también son científicos que han ido a trabajar a grandes tecnológicas? Algunos de esos también.

¿Cuándo crees que llegará la AGI? Hay un problema con la AGI: hay 20 definiciones diferentes.

¿Los grandes modelos de lenguaje son un problema? En cuanto al hecho de que los antropomorfizamos sí que es un gran problema. Pero usados con buen criterio se les puede sacar jugo. Puedes encontrar aplicaciones concretas que te ahorren trabajo.

Si escribes con estos grandes modelos surge una alteridad: ya no eres tú. Cuando he usado ChatGPT para traducir me sentía que no era yo. No podía traducir mi libro porque no es la manera como yo escribo. Aquí está la cuestión. Nos tenemos que esforzar por ser nosotros.

Ahora, con la IA, tenemos que hacer más que nunca ese esfuerzo. Así es. “El proceso de escritura genera ideas y pensamientos que de otra manera no tendríamos y, por lo tanto, mejora nuestra cognición (...) Cuando dedicamos menos tiempo a escribir se desarrolla menos nuestro sistema cognitivo, lo que puede empobrecer nuestras habilidades cognitivas generales”, dice un artículo que uso en mis presentaciones. Escribir es pensar.

La mayoría de la gente piensa poco, lee menos y no escribe... Solo faltaba eso. Le quitas incentivos para hacerlo. Los que lo hacen se están haciendo trampas al solitario. El estudiante que usa ChatGPT se está engañando.

Las chuletas existían siempre. Sí, pero para hacer la chuleta tenías que hacer un esfuerzo cognitivo para resumir y pasar a papel o a la mano. ChatGPT es menos elaborado y enriquecedor que la chuleta de toda la vida. Tengamos cuidado con lo que estamos haciendo con la IA.

[Este artículo de Algoritmo Transparente #86 también está traducido al catalán, inglés, francés e italiano.]

Share this post